২১ নভেম্বর ২০২৫

Audio Deepfake

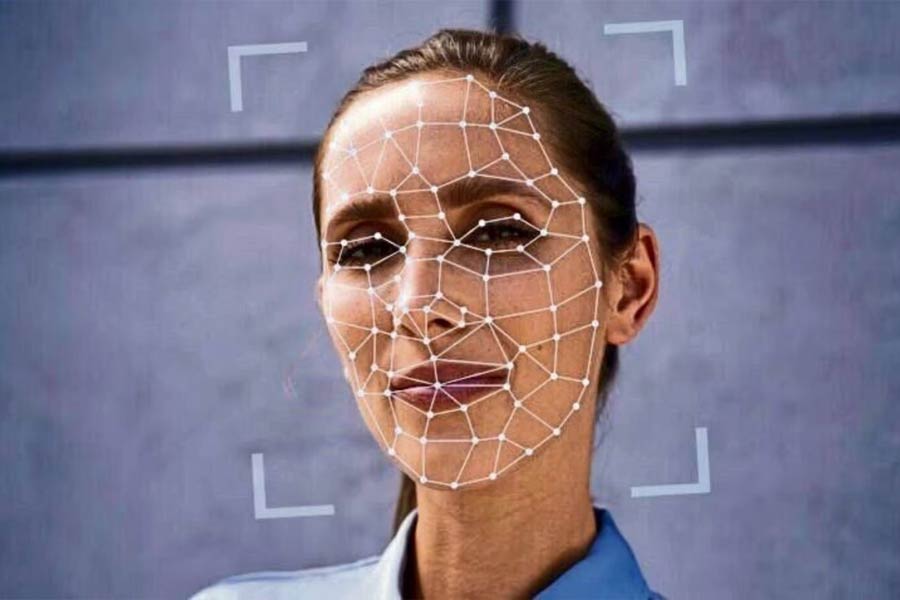

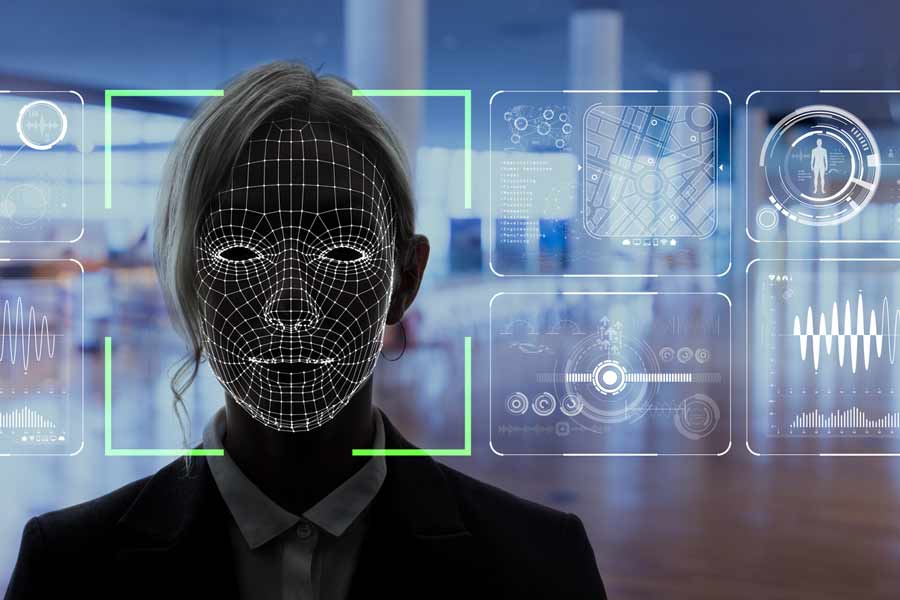

শুধু ছবি, ভিডিয়ো নয়, অডিয়োতেও আছে ‘ডিপফেক’! কী কী বিপদ ঘটতে পারে?

দক্ষিণী তারকা রশ্মিকা মন্দনার ‘ডিপফেক’ ভিডিয়ো নিয়ে সম্প্রতি তোলপাড় পড়ে গিয়েছে। ভুয়ো কারসাজির কবলে পড়েছেন বলি নায়িকারাও। তবে ‘ডিপফেক’ শুধু ছবি, ভিডিয়োতেই আর সীমাবদ্ধ নেই।

০১

১৯

০৫

১৯

০৭

১৯

০৮

১৯

০৯

১৯

১০

১৯

১১

১৯

১২

১৯

১৩

১৯

১৪

১৯

১৫

১৯

১৬

১৯

১৭

১৯

১৮

১৯

১৯

১৯

Advertisement

আরও গ্যালারি

-

সব হাড় উধাও হলেও অটুট গয়না, পোশাক! কী হয়েছিল তিন হাজার বছর কাঠের গুঁড়িতে ‘ঘুমিয়ে’ থাকা স্কার্ট পরা কিশোরীর সঙ্গে?

-

দেশরক্ষায় ট্রাম্পের ফৌজকে ডাকলেন প্রেসিডেন্ট, শুনেই ‘রে রে’ করে তেড়ে গেল লাতিন আমেরিকার দেশের জনগণ!

-

কথা ফোটার আগেই বিনোদন দুনিয়ায় পা, ছিলেন সবচেয়ে রোজগেরে শিশুশিল্পী! সাড়া ফেলতে আসছেন ‘ধুরন্ধর’ রণবীরের নায়িকা

-

একাকী জীবনে প্রেমের হাওয়া লাগবে, ’২৬-এ গাঁটছড়া বাঁধতে পারে পাঁচ রাশি! একা শুরু করলেও বছরটি শেষ হবে জোড়ায়

Share this article

CLOSEWelcome

Log in / Register

- One number & One character

- Minimum 6 character

-

Forgot Password

Or

By continuing, you agree to our terms of use

and acknowledge our privacy policy

Log In / Create Account

We will send you a One Time Password on this mobile number or email id

Or

By proceeding you agree with our Terms of service & Privacy Policy